로봇은 이미 사람들에게 너무 무겁거나 다루기 거추장스러운 물체를 들어 올리는 것과 같은 특정한 일에 능숙하다. 최근 보스턴다이내믹스가 내놓은 커다란 물체를 흡인식으로 들어 올려 이동시키는 창고·물류센터용 ‘스트레처’로봇이 이에 해당한다. 반대로 많은 수의 작은 부품이 있는 시계와 같은 품목을 정밀하게 조립하는 엡손의 정밀 자동 조립 로봇같은 것도 있다. 이 로봇의 엔드 이펙터는 너무 작아서(지름 0.32mm)여서 육안으로는 거의 보이지 않을 정도다.

산업용을 벗어나 생활 주변에서는 어떨까. 보행로를 다니는 음식배달 로봇은 미국의 대학과 도시에서는 국내와는 달리 상당히 활성화돼 있다. 물론 국내에서도 SKT나 KT가 방역용 로봇을 내놓은 것을 비롯, 인력부족이나 인건비 상승으로 어려움을 겪는 식당들을 돕는 서빙 로봇도 점진적으로 주변에서 눈에 띈다.

최근에는 어르신들과 함께 하는 동반로봇도 활발히 소개되고 있다. 빨래를 개는 휴머노이드 로봇이나 환자를 번쩍 안아 침대에 누이는 로봇도 이미 개발돼 있다. 이런 가운데 장차 독거 어르신이나 병원 환자들에게 옷을 입혀주는 보조 로봇이 미국에서 개발돼 관심을 모은다.

매사추세츠공대(MIT)의 컴퓨터 과학과와 인공지능연구소(CSAIL) 연구원들이 만든 보조로봇이 그것이다. 이 로봇은 사람과 로봇이 상호작용하는 방식의 이른바 ‘인터랙티브’ 로봇이다. 사람이 로봇의 동작에 맞춰줘 가면서 옷을 입는 방식이라는 의미다.

아직 산업용 로봇 형태를 띠고 있고 옷 입혀주는 속도도 느리다. 기존에도 옷을 입혀주는 로봇이 있긴 했다. 하지만 단순 프로그래밍 방식이어서 옷을 입히다가 멈추기를 반복하는 경직된 방식이고 속도도 느렸다.

MIT의 방식은 기계학습 알고리즘을 적용함으로써 속도를 이전보다 상당히 높였다는 점에서 한 걸음 더 나아갔다.

어떻게 로봇이 사람에게 옷을 입힐까···볼 수 없는 부분에 대한 연구

지난해 셴리와 샤 MIT교수, 그리고 다른 두 명의 MIT 연구원들은 민소매 옷을 입는 것을 도와주는 보조 로봇을 포함하는 프로젝트를 완료했다.

이제 이들은 보조로봇으로 이제 사람에게 긴팔 옷을 입히는 더 까다로운 문제에서도 진전을 보였다.

어떻게 로봇이 사람에게 팔 있는 옷을 입히는 더 어려운 과제를 해결하게 됐을까. 한마디로 로봇 시각(비전) 센서로는 볼 수 없는 부분에 대해서도 팔과 팔꿈치의 정확한 위치를 추정해 반응토록 한 것이다. 이것이 지금까지 단순 프로그래밍으로 옷을 입혀주게 한 로봇과 달라진 점이다.

MIT 항공우주학과의 셴 리는 “로봇이 인간과 상호작용하고 함께 일하면서 안전하고 성공적으로 임무를 완수하려 할 때 상황은 훨씬 더 복잡해진다”고 설명한다. MIT 인터랙티브로봇 그룹 방문 과학자인 테오도로스 스투라이티스는 “변화하는 환경 상황 속에서 거의 즉각적으로 적응하는 것을 포함한 상황 인식을 필요로 하는 작업들이 훨씬 더 어렵다”고 말한다.

셴 리는 로봇에게 민소매에 비해 팔있는 옷이 가져다 주는 가장 큰 차이는 ‘시각적 차단’에 있다고 말한다. 그는 “이 때 로봇은 전체 옷 입히기 과정 동안 사람의 팔을 볼 수 없다. 특히 로봇은 항상 팔꿈치를 보거나 정확한 위치나 방향을 결정할 수 없다. 이는 로봇이 예를 들어 긴팔 셔츠같은 옷을 손에서 어깨까지 당기기 위해 가해야 하는 힘의 양에 영향을 미친다.

연구팀은 옷 입히기 로봇에게 발생하는 이 같은 시각적 장애 문제를 다루기 위해 팔꿈치가 어느 순간에 어디에 있는지, 팔이 어떻게 기울어져 있는지를 학습을 통해 합리적이고 정확한 추측을 할 수 있는 ‘상태 추정 알고리즘’을 개발했다. 여기엔 팔꿈치를 똑바로 뻗었는지, 구부러졌는지, 위로, 아래로 향하는지, 또는 옆으로 향하는지 등이 포함된다. 이 알고리즘은 심지어 팔이 옷으로 완전히 가려져 있을 때도 이러한 추측을 할 수 있다.

이 알고리즘은 각각의 천에 힘이 가해질 때마다 측정된 값을 입력값으로 취하고 정확하지는 않지만 팔꿈치의 위치를 추정한다. 그런 다음 이를 가능한 모든 위치를 포함하는 상자 또는 볼륨 안에 위치시킨다. 이 지식이 로봇에게 움직이는 방법을 알려줘 기존 방식보다 정확한 옷 입혀 주기를 가능케 한 것이다.

스투라이티스 연구원은 “팔이 곧으면 로봇은 직선을 따를 것이고, 팔이 구부러지면 로봇은 팔꿈치 주위로 구부러질 것이다. 믿을 만한 사진을 얻는 것이 중요하다. 만약 팔꿈치 추정치가 틀리면, 로봇은 과도하고 안전하지 않은 힘을 발생시키는 움직임을 결정할 수 있다”고 말한다.

그렇다고 그것만으로 로봇이 사람에게 옷을 잘입혀줄 수는 없다. 그 과정에서 보정이 필요하다. 잘못 제어되는 힘은 어떤 방식으로 보정될까.

MIT연구팀의 알고리즘은 로봇에 옷을 입힐 사람의 팔이 향후 어떻게 움직일지 예측하는 동적 모델을 포함하고 있다. 그리고 각각의 예측은 특정 시간에 천에 가해진 측정된 힘의 양에 따라 보정하도록 했다.

그동안 다른 연구자들도 이러한 종류의 상태 추정 예측을 했지만 MIT연구팀은 차이를 보인다. MIT 팀이 이 새로운 로봇 연구에서 가장 차별화되는 것은 불확실성에 대한 명확한 상한을 설정하고 팔꿈치가 규정된 상자 안에 있을 것이라는 것을 보장한다는 점이다.

팔 움직임과 팔꿈치 위치 예측 모델과 로봇에 의해 가해지는 힘 측정 모델 모두 기계 학습 기술을 통합하고 있다.

센서가 내장된 엑스센스 정장을 입은 사람들로부터 기계학습 훈련 데이터를 얻다

기계 학습 시스템을 훈련시키는 데 사용된 데이터는 신체 움직임을 정확하게 추적하고 기록하는 센서가 내장된 엑스센스(Xsens) 정장을 입은 사람들로부터 얻었다.

로봇은 이에 기반한 기계학습 훈련을 받은 후 인간 시험참여자에게 재킷을 입힐 때 팔꿈치 자세를 유추할 수 있었다. 그는 이 과정에서 팔을 다양한 방식으로 움직였다.

때로는 로봇이 재킷을 잡아당기는 것에 반응하고 때로는 스스로 임의 동작을 하기도 한다.

이 작업은 철저히 추정(가능한 한 정확하게 팔꿈치와 팔의 위치를 결정하는 것)에 초점을 맞췄지만 연구팀은 이미 다음 단계, 즉 팔과 팔꿈치 방향의 변화에 따라 움직임을 지속적으로 조정할 수 있는 로봇 개발로 넘어가고 있다.

로봇은 과연 가만히 있는 사람에게 옷을 잘 입힐 수 있을까?

그런데 옷 입혀 주는 보조 로봇과 관련해서 한 가지 궁금증이 생긴다. 과연 로봇이 가만히 있는 사람에게 옷을 잘 입히는 걸까, 아니면 로봇이 입혀줄 때 팔을 이리저리 움직이면서 로봇에 맞추게 되는 걸까?

MIT 연구진의 실험실 동영상을 보면 로봇이 옷을 입혀주는 동안 사람은 대체로 가만히 있다. 하지만 일반 사람들이라면 그처럼 늦게 옷을 입혀주는데 가만히 참고 있기 힘들 것으로 보인다.

이와 관련, 재미있는 연구결과가 나왔다.

지난 1월 말 미국-프랑스 대학 공동 연구팀은 로봇과 상호작용하는 인간들이 로봇의 움직임을 모방하고 동기화한다는 연구결과를 내놨다. 로봇이 움직이면 사람이 거기에 장단을 맞춘다는 얘기다.

왜 우리도 어릴 때, 그리고 아플 때 누가 옷을 입혀주면 몸을 움직여서 그에 맞춰주려고 했던 기억이 있지 않는가.

그렇다면 이 국제 연구팀이 밝혀낸 대로 보조로봇이 사람에게 옷을 입혀줄 때 사람이 반드시 가만히 있으리란 법은 없을 것이다.

실제로 앞서 여러 연구에서도 사람들이 서로 교류할 때, 그들은 그들의 움직임을 동기화하는 경향이 있다는 것을 보여주었다. 그렇게 하는 것이 무의식적인 유대감의 한 형태라는 것이 제시됐다.

연구원들은 이전 몇몇 연구에서 인간과 원숭이 같은 동물들이 상호작용시 같은 종류의 동기화가 진행된다는 것을 확인했고, 이에 인간을 닮은 로봇과도 같은 방식으로 일할 수 있는지 알아봤다.

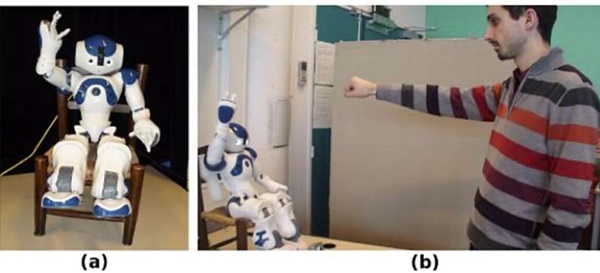

이들은 15명의 지원자들에게 인간과 로봇의 움직임을 관찰하는 동안 자율성을 가진 휴머노이드 로봇인 나오(Nao)와 상호작용(인터랙티브)하는 과정에 대해 실험했다.

나오는 인간과 기본 신체 부위가 동일하고 비슷한 방식으로 움직일 수 있어 로봇과 인간의 동시성(synchronicity)을 테스트할 수단으로 적절했다.

이 실험에서 연구원들은 사람들에게 로봇과 마주보고 앉아 그들의 팔을 로봇 앞으로 뻗은 다음 팔을 위아래로 움직이게 했다. 로봇과 인간의 상호작용을 비디오로 연구한 결과 한 명을 제외한 모든 지원자들이 결국 로봇과 팔의 움직임을 일치시켰다는 것을 발견했다.

한 사람만이 독립성을 과시하려고 의도적으로 로봇과 동기화하지 않았음이 밝혀졌다.

옷입히기 보조 외에도 다양하게 사용할 수 있다?

장차 연구진은 다른 사람들이 움직이는 특히한 방법을 해결할 수 있는 로봇을 개발해 ‘개인화’ 문제를 해결할 계획이다. 이들은 잡아당기는 힘에 서로 다르게 반응할 다양한 범위의 천 재료로 작업할 수 있을 만큼 충분히 다재다능한 로봇 개발까지 내다보고 있다.

셴 리 연구원은 이 로봇의 잠재력을 ‘옷 입혀 주기’에만 한정하지 않고 있기에 이 로봇에 사용된 알고리즘을 전문화하지 않았다고 밝히고 있다. 이 기술 잠재력이 더 넓게 사용될 것이라는 얘기다.멀지 않은 미래에 대해 생각할 수 있는 시나리오는 다음과 같다. 로봇은 저녁 식탁을 차릴 수 있고, 심지어 집안에서 아이가 식당 바닥에 남겨둔 블록들을 치워 방 한구석에 깔끔하게 쌓을 수도 있다. 로봇은 심지어 큰 접시를 테이블로 옮겨서 식사하는 사람들에게 적절한 양의 음식을 제공할 수도 있다.

MIT의 연구내용은 IEEE 로보틱스 앤 오토메이션 4월호에 실렸다.

소셜댓글